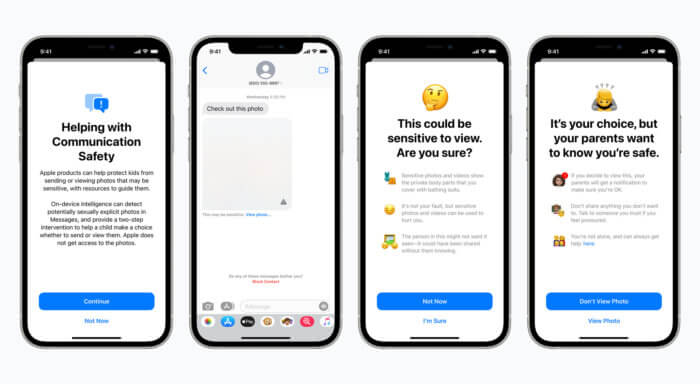

Az Apple nemrég bejelentett, új gyermekvédelmi funkciói elég alaposan felkavarták az állóvizet. Ennek kapcsán az is terjedni kezdett, hogy az Apple majd megnézné az összes fotónkat, noha erről szó sincs, illetve felbukkantak olyan aggályok is, hogy átverhető-e a NeuralHash-alapú CSAM felismerés, illetve hogy ennek milyen esetleges következményei lehetnének.

Mivel azonban mindez eleve csak az amerikai felhasználókat érintette volna, és őket is csak akkor, ha a fotóikat az iCloud Fotókban tárolják, az Üzenetekben történő felismerés pedig csak a családi megosztásban gyerekként beállított Apple ID-kra vonatkozna, illetve mindez majd csak valamikor az év vége felé érkezett volna egy szoftverfrissítéssel, így itthon ez eleve nem igazán volt érdekes kérdés. Most azonban a visszajelzések hatására az Apple úgy döntött, hogy tovább finomítja a funkciók működését, és azok egyelőre nem jelennek meg.

A 9to5Mac számára az Apple az alábbi közleményt küldte el:

Az előző hónapban olyan funkciók terveit jelentettük be, amelyek célja egyrészt segíteni a gyermekek megvédését a [szexuális] ragadozóktól, akik a kommunikációs eszközök használatával szervezik be és használják ki őket, másrészt korlátozni a gyermekpornográf tartalmak terjedését. A vásárlók, a pártfogói csoportok, kutatók és mások visszajelzései alapján úgy döntöttünk, hogy további időt szánunk az elkövetkező hónapokban arra, hogy további javaslatokat gyűjtsünk, és javításokat eszközöljünk azelőtt, hogy kiadjuk ezeket a kritikus fontosságú gyermekvédelmi funkciókat.

Ezek a funkciók tehát eleve csak az amerikai piacon jelentek volna meg, ott is csak valamikor később, egy szoftverfrissítéssel, a felismerés pedig minden esetben magán a készüléken történne. Az Üzenetek esetén a szexuális tartalmú képek felismerése csak a családi megosztásban gyermekként beállított Apple ID-k esetén lenne elérhető. A fotók esetén pedig csak akkor működne a NeuralHash-alapú CSAM felismerés, ha be van kapcsolva az iCloud Fotók, mert az csak az oda feltöltődő tartalmak esetén végezne előzetes ellenőrzést magán a készüléken, és felismerni is csak azokat a tartalmakat tudná, amelyek ismert gyermekpornográf tartalmak – tehát például a kisgyermekes szülők által a saját gyermekeikről készült fotókat nem.

Hasonló szűrést alkalmaz egyébként már régóta például a Google és a Facebook is, amelyek azonban minden feltöltött fotót meg kell vizsgáljanak ehhez, míg az Apple megoldása a NeuralHash-ek használatával mindezt azok feltöltődése előtt, magán a készüléken tenné meg anélkül, hogy az adott képek bármi adata elhagyná a készüléket.

Mindenesetre most az Apple közleménye alapján mindennek a későbbre tervezett, amerikai bevezetése is elhalasztásra kerül, meghatározatlan időre.

Érdemes elolvasni az alábbi két cikkünket a témával kapcsolatban:

nem mint ha zavarna/érdekelne, de van olyan dolog, ami nem marad ki az új rendszerből? én pl teljesen rá voltam állva, hogy tabletről a gépre át tudom húzni majd a dolgokat, de igazából minden nagy dobást kihagynak végül.

én pl teljesen rá voltam állva, hogy tabletről a gépre át tudom húzni majd a dolgokat, de igazából minden nagy dobást kihagynak végül.

Continue the discussion at Hozzászólok