Az Apple néhány nappal ezelőtt egy új aloldal közzétételével jelentette be, hogy az ősszel megjelenő rendszereihez még idén érkező frissítésekkel az amerikai piacon új, kiterjesztett gyermekvédelmi funkciókat is bevezet, ezzel is hozzájárulva ahhoz, hogy csökkenhessen a gyermekekkel szembeni szexuális visszaéléseket tartalmazó tartalmak (Child Sexual Abuse Material, CSAM) terjedése.

A gyermekvédelmi szakértők bevonásával fejlesztett eszközök három területet céloznak meg a gyermekek biztonsága érdekében: az Üzenetek app magán az eszközön futó gépi tanulással képes lesz felismerni a kényes tartalmakat, és több lehetőséget ad a szülők számára, hogy segíthessék a gyermekeiket biztonságban maradni az online térben való kommunikáció során; a kriptográfia újabb alkalmazásaival segít majd csökkenteni a CSAM tartalmak online terjedését; a Siri és a Keresés esetén pedig részletes információkat ad és segítséget nyújt majd a szülők és a gyermekek számára, ha veszélyes helyzetbe kerülnek, és közbe is lép majd, ha ilyen jellegű tartalmakra akarna valaki keresni. Mivel ez egy eléggé ambiciózus tervezet, ezért több kérdés is felmerült ennek kapcsán, amiket az Apple össze is gyűjtött egy új dokumentumban. Most ezeken a kérdéseken mennénk végig – igyekeztünk a lehető legkönnyebben érthetően leírni mindezt.

Áttekintés

Először is rögtön ki kell emelni, hogy ahogyan az az aloldal alján a *-gal jelölt lábjegyzetből látható, az Apple ezeket a funkciókat az amerikai piacon fogja bevezetni, és azok ott is csak később, az iOS 15, iPadOS 15, watchOS 8, és a macOS Monterey egy frissítésével érkeznek majd:

Mi a különbség az iMessage beszélgetések biztonságossága és az iCloud Fotók CSAM felismerése között?

A két funkció eltérő technológiát használ.

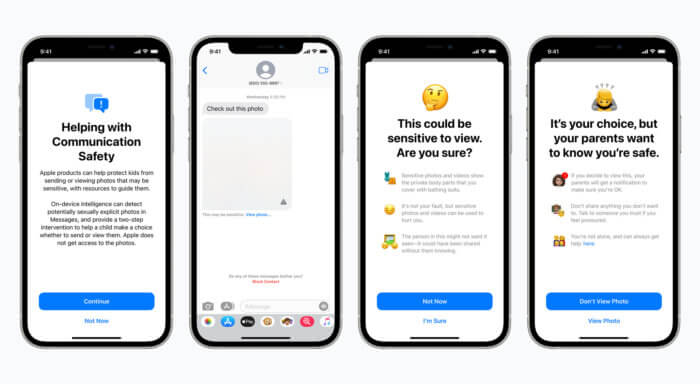

Az iMessage beszélgetések biztonságossága esetén a cél az, hogy további eszközöket biztosítson a szülők és gyermekek számára ahhoz, hogy megvédhessék a gyermeküket attól, hogy másoknak elküldjenek, illetve másoktól kapjanak szexuális tartalmú képeket. Ez a funkció csak azoknak a küldött vagy fogadott képeknek az esetén működik, amelyeket a családi megosztásban gyermekként beállított fiókokról küldenek, vagy arra érkeznek.

A funkció a képeket magán az eszközön elemzi, tehát semmiben sem változtat az Üzenetek biztonságán. Amikor egy gyermek fiókja esetén egy szexuális tartalmú kép kerül elküldésre, vagy ilyen érkezik, az adott kép csak letakarva látszódik, és a gyermek számára egy figyelmeztetés is megjelenik segítő opciókkal, és egyúttal abban is megerősíti őt ez a figyelmeztetés, hogy nincs semmi baj akkor, ha nem szeretné megnézni az adott képet, vagy pedig ha ő nem szeretne ilyen képet elküldeni:

Ezen túl pedig további elővigyázatosságból a készülék a fiatalabb gyermeket arról is tájékoztathatja, hogy ha mégis megnézné a képet, akkor a saját biztonsága érdekében a szülei értesítést kapnak erről.

A második funkció, a CSAM tartalmak iCloud Fotók esetén történő felismerése arra hivatott, hogy megakadályozza, hogy CSAM tartalom kerüljön feltöltésre az iCloud Fotókba, és teszi mindezt anélkül, hogy bármiféle információ eljutna az Apple-höz bármi más fotóról, kivéve azok esetén, amelyek megegyeznek már ismert CSAM tartalmakkal. A CSAM tartalmak birtoklása a legtöbb ország esetén törvénybe ütközik, így az USA esetén is.

Ez a funkció csak azokat a felhasználókat érinti, akik az iCloud Fotókat használják a fotóik tárolására – akik nem használják az iCloud Fotókat, azokat nem. Más, a készüléken található egyéb adatra nincs hatással. Ez a funkció nem érvényes az Üzenetek appra.

Beszélgetések biztonságossága az Üzenetekben

Ki használhatja a beszélgetések biztonságosságát az Üzenetekben?

Az Üzenetek esetén a biztonságosság csak az iCloudban családként beállított fiókok esetén érhető el. A szülő/gondviselő fiókjával be kell kapcsolni az opciót az egész család számára. A szülői értesítéseket a szülők a 12 éves vagy fiatalabb gyermekek számára engedélyezhetik.

Ez akkor azt jelenti, hogy az Üzenetek információkat fog megosztani az Apple-lel és a hatóságokkal?

Nem. Az Apple ezzel nem nyer hozzáférést az üzenetekhez. Ez a funkció nem oszt meg semmi információt sem az Apple-lel, sem az NCMEC-vel (National Center for Missing & Exploited Children), sem pedig a hatóságokkal. A beszélgetések biztonságossága opció különbözik a CSAM tartalmak felismerésétől, ami az iCloud Fotók esetén érhető el – erről részletesebben alább.

Ez akkor kikerüli az Üzenetek végpontok közötti titkosítását?

Nem. Ez semmiben sem változtatja meg az Üzenetek adatvédelmét, és az Apple sosem nyer hozzáférést a funkcióval az üzenetekhez. Az Üzenetek összes felhasználója, beleértve azokat is, akik engedélyezték a beszélgetések biztonságossága opciót, továbbra is megtartja az irányítást afelett, hogy mit küld és kinek. Ha a funkciót egy gyermek fiókja esetén aktiválták, akkor a készülék kiértékeli az Üzenetekben a képeket, és feldob egy figyelmeztetést, ha az adott kép szexuális tartalmú.

A 12 éves és annál fiatalabb gyermekek esetén a szülők beállíthatják a szülői értesítéseket, amelyek akkor kerülnek számukra elküldésre, ha a gyermek azt megerősíti és olyan képet küldene vagy kapott, amelyről a készülék megállapította, hogy szexuális tartalmú. A beszélgetés, a kép kiértékelése, a közbelépő értesítés, és a szülők számára kiküldött értesítések sem érhetőek el az Apple számára.

Megakadályozhatja mindez a bántalmazó családi környezetben élő gyermekek segítségkeresését?

A beszélgetések biztonságossága funkció kizárólag az Üzenetekben megosztott, szexuális tartalmú fotókra vonatkozik. Más, segítségkérést lehetővé tévő kommunikáció, így a megírt üzenet szövege nem tartozik ez alá. A Siri és a Keresés pedig az áldozatok – illetve az áldozatokat ismerő személyek – számára további támogatást is kínál majd azzal kapcsolatban, hogy hogyan kérhetnek segítséget.

Kapnak a szülők értesítést a gyerek figyelmeztetése és választási lehetősége nélkül?

Nem. Először is a szülőnek/gondviselőnek engedélyeznie kell az üzenetek biztonságossága opciót, és csak a 12 éves vagy fiatalabb gyermek esetén kapcsolhatja be a szülői értesítéseket.

A 12 éves és fiatalabb gyermekek esetén minden egyes szexuális tartalmú, küldött vagy fogadott kép esetén a gyermek figyelmeztetést kap arról, hogy ha megnézi az adott képet, a szülei erről értesítést kapnak. Csak akkor kapnak a szülők értesítést, ha a gyermek ezután továbblép, és megnézi (vagy elküldi) az adott képet.

A 13-17 évesek fiókjai esetén a gyermek ugyanúgy figyelmeztetést kap, és a készülék rákérdez, hogy biztosan meg akarja-e nézni, vagy el akarja-e küldeni az adott képet, de a szülők nem kapnak értesítést.

A CSAM tartalmak felismerése

Ez akkor azt jelenti, hogy az Apple az összes fotót átnézi majd a készüléken?

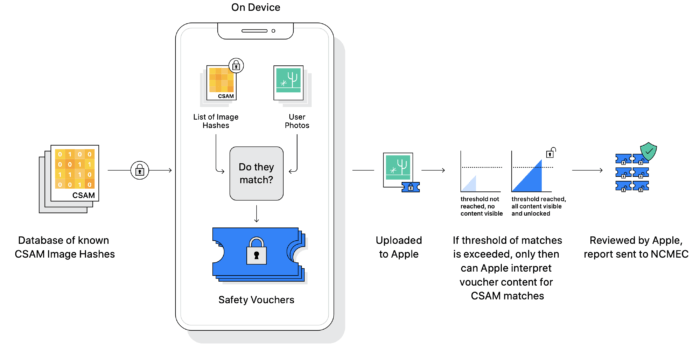

Nem. Kialakításából adódóan a CSAM felismerés csak az iCloud Fotókba feltöltésre kiválasztott képekre érvényes, és ebben az esetben is az Apple csak az adott fiókokról szerez értesülést, amelyek ismert CSAM tartalmakat is tárolnak, és kizárólag azokról a képekről értesül, amelyek megegyeznek ismert CSAM tartalmakkal. Ez a rendszer nem működik azoknál a felhasználóknál, akik letiltották az iCloud Fotókat, illetve a csak a készüléken tárolt fotókkal sem.

Letöltődnek majd emiatt CSAM tartalmak a készülékemre, hogy összehasonlíthatóak legyenek a fotóimmal?

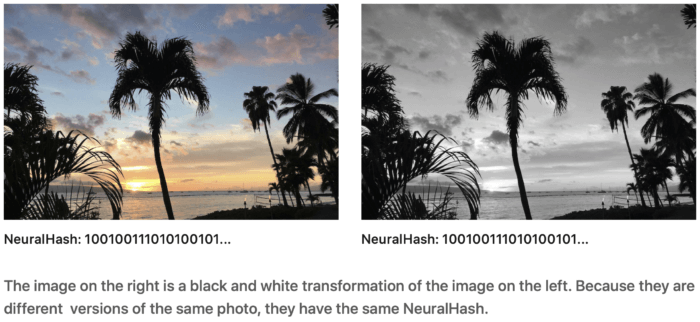

Nem. CSAM tartalmak nem kerülnek a készülékre. A tényleges képek helyett az Apple NeuralHash hash-eket használ: ezek gyakorlatilag számsorok, amelyek az ismert CSAM képekből kerültek generálásra, és azok módosított változatait is képesek felismerni, viszont nem állíthatók vissza belőlük az eredeti CSAM képek. Az ezeknek a hash-eknek alapjául szolgáló, igazoltan CSAM képeket gyermekvédelmi szervezetek biztosították.

Új kriptográfiai módszerekkel ezek a hash-ek felhasználhatóak ahhoz, hogy beazonosíthatóak legyenek azok az iCloud Fotók fiókok, amelyekben olyan képek vannak, amelyek ismert CSAM tartalmak, és csak azokról a képekről szerezzen információt az Apple, amelyek ténylegesen CSAM képek, anélkül, hogy bármelyik másik fotó a szórásba kerülne.

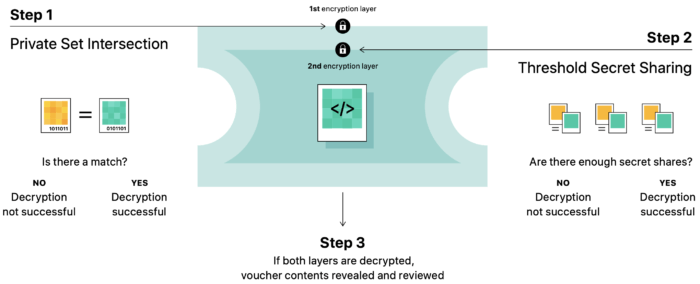

Ez az azonosítási módszer a private set intersection (PSI) kriptográfiai technológiát használja, amely anélkül állapítja meg, hogy van-e egyezés, hogy felfedné az eredményt. A PSI használatával az Apple képes anélkül megismerni, hogy egy kép hash-e egyezik-e ismert CSAM kép hash-ével, hogy bármi más, ilyen tartalommal nem rendelkező képről bármit is megtudna. A PSI egyúttal a felhasználót is megakadályozza abban, hogy kideríthesse, van-e egyezés.

A készülék ezután létrehoz egy kriptográfiai biztonsági vócsert (cryptographic safety voucher), ami az egyezés eredményét tartalmazza kódoltan. Ezen túl titkosítja az adott kép NeuralHash hash-ét és egy vizuális származékot (visual derivative). Ez a vócser a képpel együtt feltöltésre kerül az iCloud Fotókba. Ezután egy másik technológia, a threshold secret sharing segítségével a rendszer biztosítja, hogy a biztonsági vócser mindaddig nem értelmezhető az Apple számára, ameddig az adott fiók esetén át nem lép egy küszöbértéket az ismert CSAM tartalmak mértéke.

A threshold secret sharing segítségével a titkosított adat több részre van darabolva, hogy a titkosított adat csak akkor legyen visszaállítható, ha átlépi a küszöböt az elérhető adatok mennyisége. Például ha a titkosított adat 1000 darabra van felosztva, és a küszöbérték 10, akkor az adat visszaállítható az 1000-ből bármely 10 darab felhasználásával. Ha viszont csak 9 darab van meg, akkor nem állítható vissza.

Amennyiben megtörtént a küszöb átlépése, a technológia csak akkor teszi lehetővé az Apple számára, hogy elvégezze az emberi ellenőrzést. A küszöbérték úgy lett beállítva, hogy kifejezetten magas pontosságú legyen, és így ne jelölhessen meg fiókokat hibásan. Ezt pedig követi az emberi ellenőrzés minden egyes ilyen jelentés esetén, és annak igazolása, hogy valóban tényleges találatról van szó. Ha ez a helyzet, akkor az Apple letiltja a felhasználó fiókját, és jelentést küld az NCMEC-nek. Amennyiben egy felhasználó úgy gondolja, hogy hibásan került be a fiókja ebbe a szórásba, fellebbezést nyújthat be az Apple-nek a döntés ellen a fiókja visszaállítása érdekében.

Miért most lép az Apple ebben az ügyben?

Az egyik legnagyobb kihívás ebben az esetben az, hogy a gyermekek védelme mellett a felhasználók adatainak a védelme se sérüljön. Ennek az új technológiának köszönhetően az Apple tudomást szerezhet az iCloud Fotókban tárolt, ismert CSAM tartalmakról, ha egy adott fiók több ismert CSAM tartalmú fotót is tárol. Az Apple ezzel sosem szerez információt a felhasználó egyéb, csak a készülékén tárolt adatáról.

A jelenlegi, más cégek által alkalmazott technikák az adott felhasználó összes, a felhőben tárolt fotóját átnézik. Ez egy adatvédelmi kockázatot jelent az összes felhasználó számára. Ezzel szemben a CSAM tartalmak felismerése az iCloud Fotók esetén jelentős adatvédelmi előnyöket kínál, mert megakadályozza, hogy az Apple bármi információhoz jusson a fotókról, kivéve ha azok megegyeznek ismert CSAM tartalmakkal és olyan fiók tárolja őket az iCloud Fotókban, amelyik esetén több ilyen kép is megtalálható ott.

A CSAM-felismerés biztonságossága az iCloud Fotók esetén

Használható a CSAM-felismerő rendszer az iCloud Fotókban nem csak CSAM tartalmak keresésére?

A folyamat úgy lett kialakítva, hogy ezt megakadályozza. A CSAM felismerő rendszer csak azoknak a CSAM tartalmaknak a hash-eivel működik, amelyet az NCMEC és más gyermekvédelmi szervezetek biztosítanak, amelyeket ők ellenőriztek és igazoltan CSAM tartalomként megjelöltek. A folyamat során nincs automatizált rendszer, ami jelentene a hatóságok felé, és az Apple egy emberi ellenőrzést hajt végre azelőtt, hogy jelentene egy esetet az NCMEC-nek. Ennek eredményeként a rendszer kizárólag az iCloud Fotókban tárolásra került, ismert CSAM tartalmak jelentésére képes. A legtöbb országban, így az Egyesült Államokban is már az ilyen képek birtoklása is bűncselekménynek minősül, így az Apple bármely ilyen esetet köteles jelenteni a megfelelő hatóságok felé.

Kényszeríthetik kormányok az Apple-t arra, hogy nem CSAM képeket is felvegyen a listába?

Az Apple megtagad minden ilyen követelést. A cég CSAM felismerési képessége kizárólag az iCloud Fotókban tárolt, az NCMEC szakértői és más gyermekvédelmi csoportok által CSAM tartalomnak minősített, előttük is ismert képek megkeresésére készült. Az Apple már korábban is szembesült olyan kormányzati követelésekkel, amelyek a felhasználók magánélethez való jogát csökkentették volna, és a cég határozottan elutasította az ilyen követeléseket, és a cég hozzáállása ezzel kapcsolatban azóta is változatlan.

Ez a technológia kizárólag a felhasználók által esetlegesen az iCloudban tárolt, ismert CSAM tartalmak felismerésére van korlátozva, és a cég nem fog egyetlen kormány azon kérésének sem eleget tenni, hogy ez más tartalmakra is kiterjedhessen. Ezen felül pedig az Apple minden esetben egy emberi ellenőrzést is végrehajt azelőtt, hogy jelentést küldene róla az NCMEC-nek. Abban a valószínűtlen esetben, ha a rendszer esetleg mégis olyan fotókat jelölne meg CSAM-ként, amelyek nem egyeznek meg az ismert CSAM tartalmakkal, akkor az érintett fiók nem kerül letiltásra, és az NCMEC sem kap róla jelentést.

Lehetséges nem CSAM tartalmú fotók “injektálása” a rendszerbe, hogy az más, nem CSAM tartalmakat is megjelölhessen?

A folyamat úgy lett megtervezve, hogy ezt megelőzze. A felismeréshez használt hash-ek ismert, meglévő CSAM tartalmú képekből származnak, amelyeket gyermekvédelmi szervezetek szereztek meg és ellenőriztek. Az Apple nem ad hozzá ezeknek a hash-eknek a listájához. Ugyanaz a hash-készlet található meg az összes iPhone és iPad operációs rendszerében, így az adott emberekkel szembeni, célzott támadások nem lehetségesek a kialakítás miatt. Végezetül pedig, nincs automatizált jelentésküldés a hatóságok felé, és az Apple minden esetben egy emberi ellenőrzést is végrehajt azelőtt, hogy jelentést küldene róla az NCMEC-nek. Abban a valószínűtlen esetben, ha a rendszer esetleg mégis olyan fotókat jelölne meg CSAM-ként, amelyek nem egyeznek meg az ismert CSAM tartalmakkal, akkor az érintett fiók nem kerül letiltásra, és az NCMEC sem kap róla jelentést.

Előfordulhat, hogy a CSAM felismerés hibásan jelöl meg ártatlan embereket?

Nem. A rendszer úgy lett megtervezve, hogy nagyon pontos legyen, és annak a valószínűsége, hogy egy fiókot hibásan jelöljön meg, egy a trillióhoz évente. Ezen túl minden alkalommal, amikor egy fiókot megjelöl a rendszer, az Apple emberi ellenőrzést hajt végre azelőtt, hogy az esetet jelentené az NCMEC-nek. Így az esetlege rendszerhibák vagy támadások nem eredményezhetik azt, hogy ártatlanok kerüljenek bejelentésre az NCMEC-nél.

Bajba kerülhet valaki, ha a saját gyermekéről készített meztelen képeket?

Nem, mert ezek a képek nem fognak egyezni ismert CSAM tartalmakkal. A funkció kizárólag a gyermekvédelmi szervezetek által már ismert, és általuk igazoltan CSAM tartalomnak jelölt képeket képes felismerni. A saját magunk által készített képeket nem. (Abba most nem mennénk bele, hogy a gyermek személyiségi jogai hogyan alakulnak ebben a kérdésben, mert ez az adott szülők döntésköre és felelősége.)

Összefoglalva

Ahogyan az már a legelején kiderült, ez az új funkcionalitás kizárólag az USA esetén lép majd életbe valamikor még idén, az iOS 15, iPadOS 15, watchOS 8, és a macOS Monterey egy frissítésével. Az itthoni felhasználókat tehát ez semmilyen formában nem érinti. Arról jelenleg nincs információ, hogy a jövőben az Apple ezt kiterjeszti-e más országokra is.

A készülék csak abban az esetben végez, és akkor is csak magán a készüléken történő, hash-alapú összehasonlítást a fotókon az ismert CSAM tartalmak hash-eivel, ha az adott képek feltöltésre kerülnének az iCloudba az iCloud Fotók bekapcsolt állapota esetén. Nincs CSAM felismerés egy kép esetén sem, ha az iCloud Fotók kikapcsolt állapotú.

Ez a módszer megoldás lehet a gyermekvédő szervezetek által már ismert képek azonosítására, de azok ellen értelemszerűen nem véd, amelyek még nem kerültek el hozzájuk.

Az Üzenetekben érkezett vagy elküldött képek esetén 12 éves és fiatalabb gyermekek fiókjainál a szülő/gondviselőnek külön engedélyezni kell a szülői értesítéseket, és így amikor a gyermek szexuális tartalmú képet kap vagy olyat küldene, és rányom a megtekintésre, vagy pedig a küldésre, akkor a figyelmeztetés elfogadása után a szülő erről értesítést kap. Ha a gyermek inkább nem nézi meg vagy küldi el az adott képet, akkor a készülék nem küld értesítést a szülőnek. A 13-17 évesek esetén a figyelmeztetés ugyanúgy megjelenik ilyen esetben, de a szülői értesítés nem kapcsolható be rájuk.

Kapcsolódó tartalmakként ezeket lehet érdemes elolvasni:

- Expanded Protections for Children — Frequently Asked Questions (PDF)

- Expanded Protections for Children — Technology Summary (PDF)

- CSAM Detection — Technical Summary (PDF)

- Apple PSI System — Security Protocol and Analysis (PDF)

- Technical Assessment of CSAM Detection — Benny Pinkas (PDF)

- Technical Assessment of CSAM Detection — David Forsyth (PDF)

- Technical Assessment of CSAM Detection — Mihir Bellare (PDF)

- Alternative Security Proof of Apple PSI System — Mihir Bellare (PDF)

Ez nagyon gáz…

Már fel se merem tenni, hogy mi ebben a gáz, mert 99%-ban sejtem a választ.

Biztos tele van a készüléke ilyen fotókkal

Talán az a gáz hogy most csak ezek a fotók aztán legkozelebb majd más, lehet nem fotók, hanem üzenet részletek stb. Persze az ember ne tartson ettől ha ugy se csinál semmi rosszat… de ja, egy újabb kiskapu az államnak/ cégeknek az mindig üdvözlendő, hiszen értünk van!

Jaj de jót nevettünk.

ha elolvastad a fenti cikket, akkor láthatod, hogy nincs kiskapu.

a funkció magán a készüléken végez ellenőrzést, és azt is kizárólag akkor teszi majd, ha amerikai ügyfél vagy ÉS be van kapcsolva az iCloud Fotók, és így a fotóid és videóid feltöltődnének a felhőbe. ha nincs bekapcsolva az iCloud Fotók, ellenőrzés sincs.

a saját magad által készített, ilyen jellegű fotókat sem fogja tudni felismerni, mert csak olyan képeket talál meg, amelyek már ismertek az NCMEC számára.

de mivel nem vagy amerikai, így egyáltalán nem érint majd mindez, és arról pedig semmi hír nincs, hogy a jövőben az Apple ezt kiterjesztené-e bármi más országra is, és hogy mikor.

Persze ez világos, de pesszimista vagyok ezekkel kapcsolatban, hiszen ahogy írtam most csak ennyi és csak US, aztán legközelebb majd kicsit módositanak rajta és EU-ban is lesz, akkor meg már nem fogja ennyire se érdekelni az embereket…

na jó, és ha lesz, akkor mi lesz? ha nem használsz iCloud Fotókat, akkor semmi. ha meg használsz is, akkor is csak az igazolt, ismert CSAM tartalmakat tudja maga a készüléked felismerni, vagyis ha nem töltesz le ilyen tartalmat, amit utána az iCloudban akarsz tárolni, akkor sem lesz semmi. a saját gyerek lefotózásával meg nem gyártasz ilyen tartalmat, hiszen az nem jut el az NCMEC-hez, akik a NeuralHash hasheket generálták, amit a készülék a felismeréshez használ.

A na jó és akkor mi lesz anekdótát szerintem ismerjük… Hagyd ezt a részt, a technikai részt már leírtátok, nem ez a lényeg, hanem hogy mi lesz a következő megoldando dolog amit a tech cégek feladatnak vesznek majd.

szerintem ezen felesleges elÅre aggódni.

Continue the discussion at Hozzászólok